A Confluent, em colaboração com o Google Cloud, lançou uma postagem no blog ilustrando como as organizações podem aproveitar modelos de linguagem grandes (LLMs) para automatizar a geração de consultas SQL, simplificando os fluxos de trabalho de análise de dados. O artigo apresenta uma solução completa e poderosa para processamento de dados e insights em tempo real, integrando LLMs com Confluent e Vertex AI.

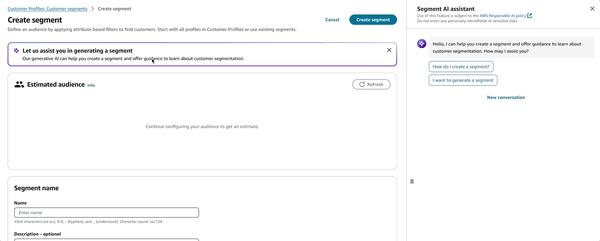

O que me chamou a atenção particularmente foi a capacidade dos LLMs de capacitar usuários empresariais com experiência limitada em SQL a explorar conjuntos de dados de forma eficiente. Ao aproveitar os prompts de linguagem natural, os usuários podem interagir com o sistema e obter insights valiosos sem a necessidade de formular consultas SQL complexas.

Um dos principais problemas abordados por essa tecnologia são os desafios associados à escrita de consultas SQL complexas. Escrever e otimizar tais consultas geralmente requer habilidades especializadas de engenharia de dados e é demorado. Ao automatizar esse processo usando LLMs, as organizações podem economizar tempo e recursos, reduzindo o risco de erros.

Além disso, a integração de LLMs com os recursos de streaming em tempo real do Confluent aborda a questão da análise de dados em tempo real. Ao contrário dos métodos tradicionais de processamento em lote, que geralmente carecem da velocidade e agilidade necessárias para a tomada de decisões em tempo real, essa solução garante que os insights estejam prontamente disponíveis, permitindo que as empresas tomem decisões proativas.

No geral, considero a integração de LLMs, Confluent e Vertex AI um passo significativo no campo da análise de dados. Ao automatizar a geração de consultas SQL e habilitar o streaming em tempo real, essa solução capacita as organizações a superar os desafios tradicionais e liberar todo o potencial de seus dados.