O Google Cloud publicou um guia prático sobre como maximizar a taxa de transferência de veiculação de LLM para GPUs no GKE.

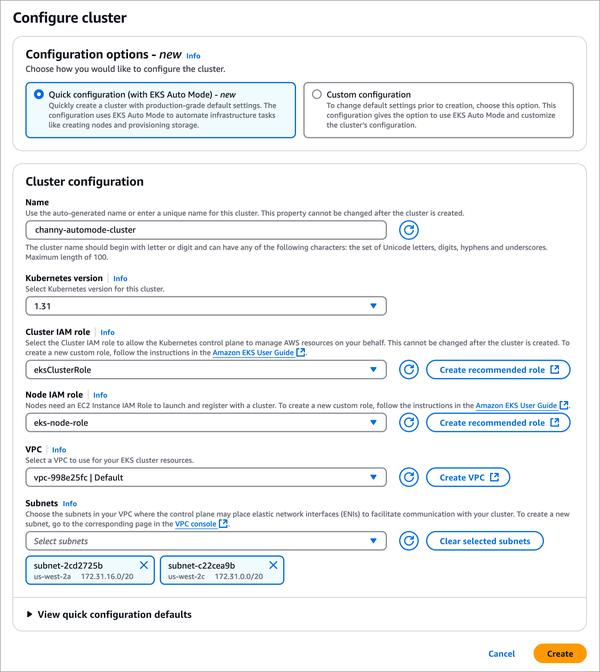

Esta postagem do blog aborda o desafio de veicular grandes modelos de linguagem (LLMs) com boa relação custo-benefício. O GKE, com recursos como escalabilidade automática de carga de trabalho e infraestrutura e balanceamento de carga, oferece uma solução para veiculação de LLM com boa relação custo-benefício.

A postagem do blog fornece recomendações práticas para maximizar a taxa de transferência de veiculação em GPUs NVIDIA no GKE, incluindo:

* **Decidir se deve quantizar o modelo e qual quantização usar.** A quantização FP16 e Bfloat16 fornece praticamente a mesma precisão que FP32 com metade do uso de memória.

* **Escolher um tipo de máquina que se ajuste ao modelo.** Escolher o tipo de máquina certo depende do número de parâmetros no modelo e do tipo de dados dos pesos do modelo.

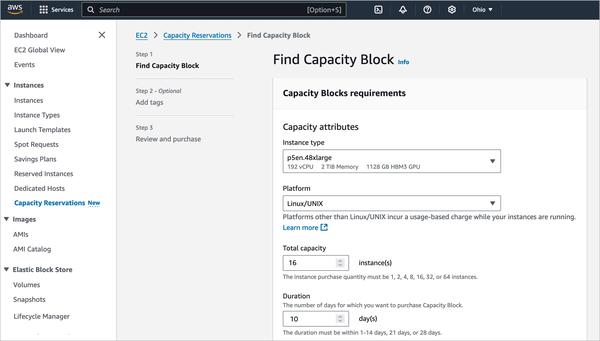

* **Escolher a GPU certa.** O GKE oferece uma variedade de VMs com tecnologia de GPU NVIDIA. Escolher a GPU certa depende das características do modelo e dos requisitos de desempenho.

Além disso, a postagem do blog discute como otimizar uma plataforma de servidor de modelo para uma determinada carga de trabalho de inferência, incluindo:

* **Otimizando para casos de uso com uso intenso de entrada vs. casos de uso com uso intenso de saída.** A inferência de LLM envolve duas fases: preenchimento e decodificação.

* **Como o processamento em lote afeta o desempenho.** As solicitações em lote são essenciais para atingir uma taxa de transferência mais alta, pois utilizam mais memória de GPU, largura de banda HBM e FLOPS de GPU sem aumentar o custo.

No geral, a postagem do blog fornece orientação prática para maximizar a taxa de transferência de veiculação de LLM em GPUs no GKE. Ao seguir essas recomendações, as organizações podem minimizar o custo de veiculação de LLMs, ainda fornecendo alto desempenho.