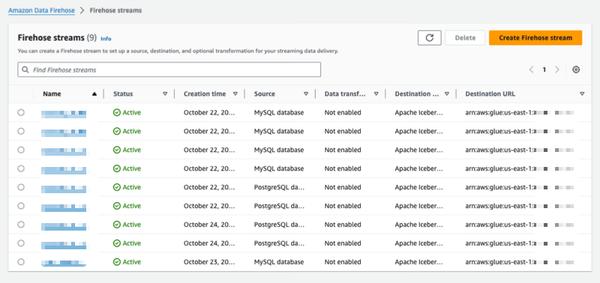

O Amazon Data Firehose apresenta um novo recurso que captura alterações de bancos de dados como PostgreSQL e MySQL e replica atualizações para tabelas Apache Iceberg no Amazon S3. Isso oferece uma solução simples e completa para streaming de atualizações de banco de dados sem impactar o desempenho das transações. Os usuários podem configurar um stream do Data Firehose em minutos para entregar atualizações de captura de dados de alteração (CDC) de seus bancos de dados. Agora eles podem replicar facilmente dados de diferentes bancos de dados em tabelas Iceberg no Amazon S3 e usar dados atualizados para análises em grande escala e aplicações de aprendizado de máquina (ML). Os clientes corporativos da AWS normalmente usam centenas de bancos de dados para aplicações transacionais. Para realizar análises em grande escala e ML nos dados mais recentes, eles desejam capturar as alterações feitas nos bancos de dados, como quando os registros são inseridos, modificados ou excluídos em uma tabela, e entregar atualizações para seu data warehouse ou data lake do Amazon S3 em formatos de tabela de código aberto como o Apache Iceberg. Muitos clientes desenvolvem trabalhos de extração, transformação e carregamento (ETL) para ler periodicamente de bancos de dados. No entanto, os leitores ETL impactam o desempenho das transações do banco de dados e os trabalhos em lote podem adicionar horas de atraso antes que os dados estejam disponíveis para análise. Para mitigar isso, os clientes desejam transmitir as alterações feitas no banco de dados, o que é chamado de stream CDC. Com esse novo recurso de streaming de dados, o Data Firehose adiciona a capacidade de adquirir e replicar continuamente streams CDC de bancos de dados para tabelas Apache Iceberg no Amazon S3. Os usuários configuram um stream do Data Firehose especificando a origem e o destino. O Data Firehose captura e replica um snapshot de dados inicial e todas as alterações subsequentes nas tabelas de banco de dados selecionadas como um stream de dados. Para adquirir streams CDC, o Data Firehose usa o log de replicação do banco de dados, reduzindo o impacto no desempenho das transações do banco de dados. Quando o volume de atualizações do banco de dados flutua, o Data Firehose particiona automaticamente os dados e persiste os registros até a entrega. Os usuários não precisam provisionar capacidade ou gerenciar clusters. O Data Firehose também pode criar automaticamente tabelas Apache Iceberg usando o mesmo esquema que as tabelas do banco de dados durante a criação inicial do stream e desenvolver automaticamente o esquema de destino com base nas alterações do esquema de origem. Como um serviço totalmente gerenciado, o Data Firehose elimina a necessidade de componentes de código aberto, atualizações de software ou sobrecarga operacional.

Replicar alterações de bancos de dados para tabelas Apache Iceberg usando o Amazon Data Firehose (em visualização)

AWS