A Meta lançou os modelos Llama 3.2, uma família inovadora de modelos de linguagem com recursos aprimorados, aplicabilidade mais ampla e suporte a imagens multimodais, agora disponível no Amazon Bedrock. Este lançamento representa um avanço significativo em modelos de linguagem grandes (LLMs), oferecendo recursos aprimorados e aplicabilidade mais ampla em vários casos de uso.

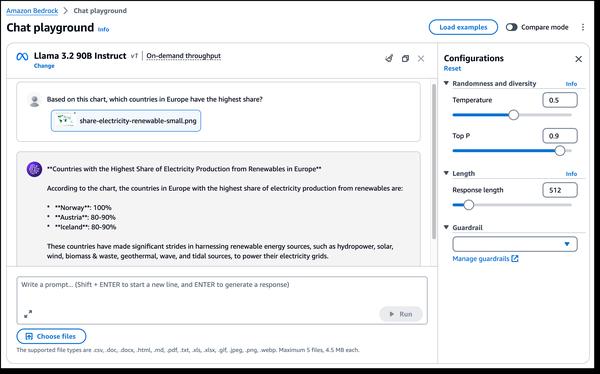

Um dos aspectos mais interessantes do Llama 3.2 é a introdução de recursos de visão multimodal. Os novos modelos 90B e 11B são projetados para compreensão de imagens e raciocínio visual, abrindo novas possibilidades para aplicações como legendagem de imagens, recuperação de imagens e texto e perguntas e respostas visuais. Esses recursos podem revolucionar a maneira como interagimos e utilizamos imagens em diferentes domínios.

Além disso, o Llama 3.2 oferece modelos leves adequados para dispositivos de ponta. Os modelos 1B e 3B são projetados para serem eficientes em termos de recursos, com latência reduzida e desempenho aprimorado, tornando-os ideais para aplicações em dispositivos com recursos limitados. Isso pode levar ao desenvolvimento de assistentes de escrita baseados em IA mais inteligentes e aplicativos de atendimento ao cliente em dispositivos móveis.

Além disso, o Llama 3.2 é construído sobre o Llama Stack, uma interface padronizada para construir componentes de cadeia de ferramentas canônicos e aplicativos agentivos, tornando a construção e a implantação mais fáceis do que nunca. Isso fornece aos desenvolvedores uma maneira padronizada e eficiente de integrar os modelos Llama em seus aplicativos.

No geral, o lançamento do Llama 3.2 marca um passo significativo no campo dos modelos de linguagem grandes. Seus recursos aprimorados e aplicabilidade mais ampla abrem novas possibilidades para uma ampla gama de casos de uso, desde compreensão de imagens e raciocínio visual até aplicações de ponta. À medida que a tecnologia de IA generativa continua a evoluir, podemos esperar mais inovações e aplicações transformadoras de modelos como o Llama 3.2.